Wer sich beim Lesen nicht wiederfindet, dem spendiere ich einen Kaffee – das wird ein interessantes Gespräch!

Smart schlägt Big (Data)

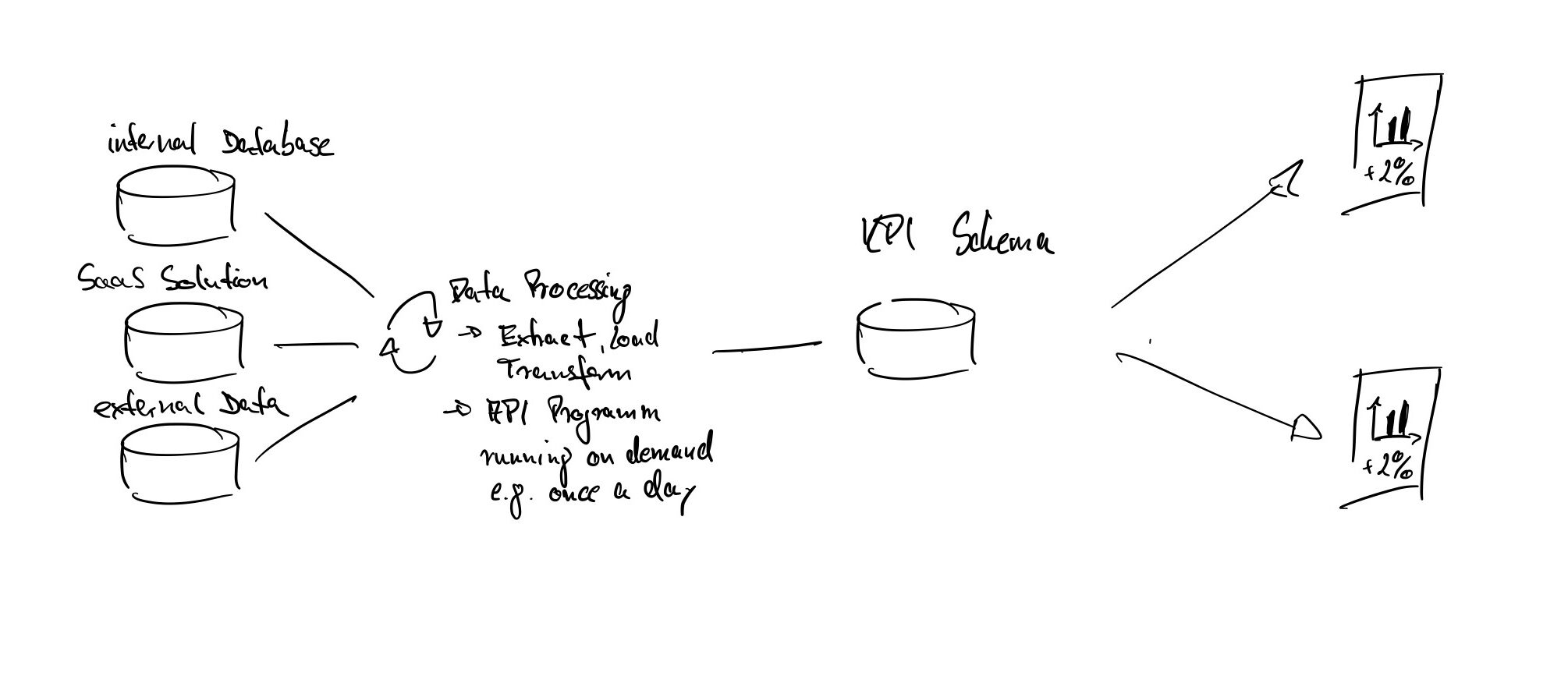

Daten sind das neue Öl und dessen Speicherung kostet quasi nichts. Doch was machen wir mit dem ganzen Öl? Wir entwickeln Pipelines, um das Öl aus den unterschiedlichsten Reservoirs in große Speicher zu leiten und auf dem Weg dorthin so anzureichern, dass wir später auch alles wiederfinden. Wir ermöglichen cross-funktionalen Projektteams Werkzeuge und Datentöpfe für die unterschiedlichsten Fragestellung auch kurzfristig heranzuziehen. Wir implementieren komplexe Systeme und Regelwerke zum Schutz der Daten und zur Einhaltung der rechtlichen Aspekte. Infrastruktur- und Prozessautomatisierung sollen Workload und Geschwindigkeit sicherstellen. Um die KI Leiter zu erklimmen, sollen hybride Multicloud Architekturen dabei unterstützen, immer spezifischere, business-relevante Fragestellungen beantworten zu können und Entscheidungen daten-getrieben zu begründen.

Sicher ist, die Aufwände bei Aufbau und Betrieb des Ölspeichers steigern direkt die smarten Möglichkeiten in der Raffinerie!

Data Science und Machine Learning Projekte folgen strikt dem Pareto Prinzip

Heute haben wir die die technischen Möglichkeiten relativ einfach Stammdaten aus den ERP Systemen mit Transaktionsdaten aus anderen Systemen zu verbinden, für Analysen können wir Self-Service Analytics Tools nutzen. Wer mit Daten arbeitet, wird bestätigen – 20% der Arbeit erzeugen 80% des Wertes! Die übrigen 80% der Zeit müssen aufgebracht weren, um die Daten überhaupt nutzen und vergleichen zu können.

Wieso? Effizientes Datenmanagement ist die Grundlage für eine wertschöpfende Analyse! Der Single Point of Truth und die Wichtigkeit der Datenqualität sind seit Jahren Dauerbrenner. Während wir über AI enabled Milchkannen mit 5G reden und Leuchtturm Projekte feiern, scheitern viele Bemühungen nicht selten an bekannten Themen des Data Management.

Ob EDV oder IT, wir verdichten Daten mittels Semantik zu Informationen, um Informationen zu vernetzten und daraus Wissen zu generieren. Wir nennen es heute Data oder Advanced Analytics:

- Descriptive Analytics = Was ist passiert? Die klassische Disziplin der Business Intelligence

- Predictive Analytics = Was wird wahrscheinlich passieren? Entwicklung von Modellen zur Vorhersage von Eintrittswahrscheinlichkeiten bestimmter Ereignisse (typischerweise Machine Learning)

- Prescriptive Analytics = Welche Handlungen sollten bei Eintreten eines Ereignisses ausgeführt werden, um optimal zu reagieren und Risiken zu minimieren?

Betrachten wir zur Vereinfachung nur den Bereich der Business Intelligence (Descriptive Analytics). Zur Entscheidungsunterstützung analysieren wir vorhandene Unternehmensdaten und präsentieren diese meist aggregiert als Report oder Dashboard. Auf Basis dieser Reports und Dashboards treffen wir Entscheidungen.

Ausgehend von business-relevanten Fragestellungen werden diese Reports entwickelt. Zu Beginn der Entwicklungen müssen die notwendigen Daten zur Verfügung stehen – klingt simple, kann aber die erste Hürde sein. Maßnahmen, wie das Aufbrechen von Datensilos und der Aufbau einer Data Governance gehören, aus unterschiedlichsten Gründen, meist nicht zu dem liebsten Tätigkeiten in Unternehmen. Dennoch sollten der Ursprung und die Bedeutung der Daten, sowie die Datenqualität für eine aussagekräftige Analyse bekannt sein – idealerweise durchgängig nachvollziehbar. Häufig wissen nur die betreuenden Fachabteilungen, welche Annahmen einer KPI zugrundeliegen und wie die Daten zu interpretieren sind.

Das Thema Data Management ist relevanter denn je, weil wir daten-gestützt Entscheidungen treffen!

Steigende Benutzerfreundlichkeit senkt Eintrittsbarrieren

Was vor einiger Zeit noch hochqualifizierten Fachkräfte vorbehalten war, wird heute für eine viel breitere Masse an Menschen zugänglich. Betrachten wir exemplarisch die Machine Learning Funktionen (AutoML) in Analytics Tools. Heute kann ich die betrachteten Datenquellen in meinem Analytics Tool verknüpfen und analysieren. Die AutoML Funktion übernimmt das Feature Engineering – ohne dass der Anwender weiterführende Kenntnisse zur Methodik und der statistischen Aussagekraft haben muss, können vermeintliche Zusammenhänge erkannt werden. Die Ergebnisse der Analysen extrapolieren die Anwender zu Handlungsempfehlungen und exportieren die dazugehörigen Charts schnell in die PowerPoint für das nächste Meeting.

Die sinkenden Eintrittsbarrieren bei der Nutzung von Plattformen, Anwendungen und Funktionen verdeutlichen die Chancen und Risiken, die (notwendige) Geschwindigkeit und die veränderten Anforderungen an die Skillsets der Mitarbeiter und Entscheidungsträger.

Transformation und Kultur

Auch die besten daten-gestützten Entscheidungen brauchen die richtigen Fragen – von klugen Köpfen, die vernetzt denken und handeln. Daten schaffen erst einen Wert, wenn wir sie operationalisieren. Das Sammeln von Daten reicht i.d.R. nicht. Viel mehr kommt es auf die Fähigkeit an, diese Daten für bessere und schnellere Entscheidungen zu nutzen. Die Fähigkeit der Nutzung wird durch die Skillsets der Mitarbeiter und den Zugang zu Daten und Werkzeugen bestimmt. Wenn die Anforderungen an die Fähigkeiten der Mitarbeiter steigen, braucht es eine Führung, die bereit ist, den „Haben wir immer so gemacht.“ Weg durch „Das probieren wir aus, messen und iterieren.“ zu ersetzen. Entscheidungen, die daten-gestützt nicht mehr haltbar sind, sollten auch revidiert werden.

Wetten, dass…?

Wem die Transformation gelingt und wer bessere, schnellere Entscheidungen treffen kann, der ist näher an den Kundenbedürfnissen und mittelfristig erfolgreicher.

[…] Mal geht es um die Frage, an welchen Voraussetzung wir meiner Meinung arbeiten sollten, wenn wir daten-getriebene Geschäftsmodelle und Innovationen ermöglichen […]